- self supervised

Digging Into Self-Supervised Monocular Depth Estimation 논문 리뷰

MonoDepth 2 리뷰

- 조명/재질 처리

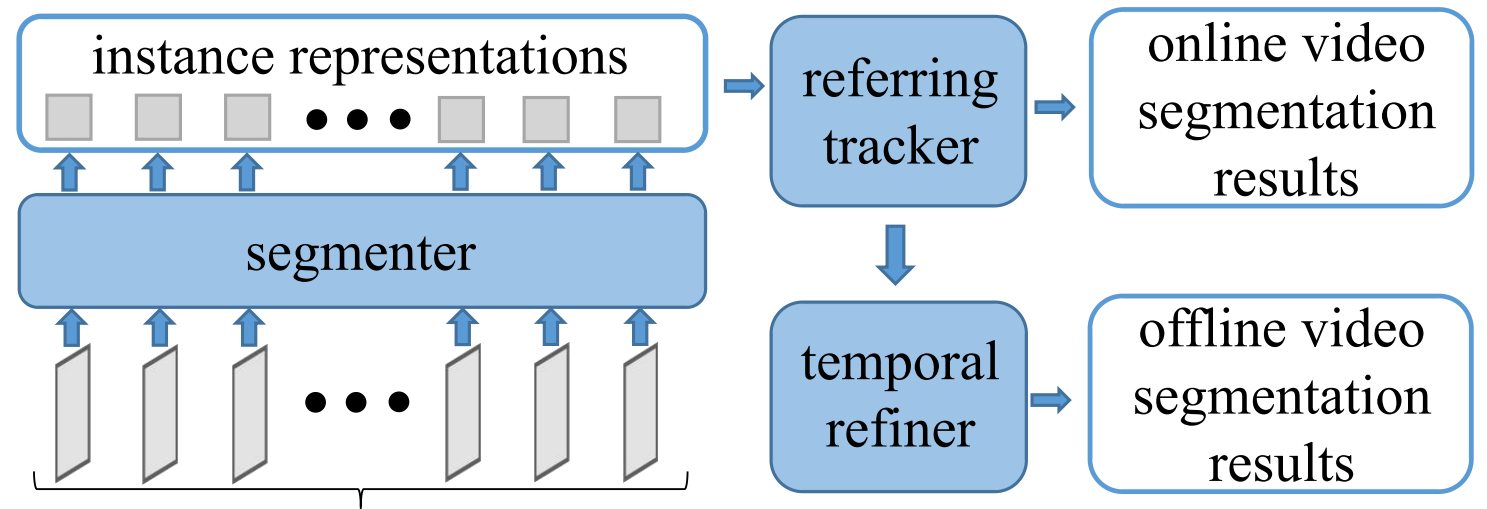

- 객체 추적 (시각적 일관성) → SSM(state space model)을 통한 개선

- 복잡한 장면 처리

- 계산 효율성 → SSM을 통한 개선

- self-supervised

- 시각적 일관성

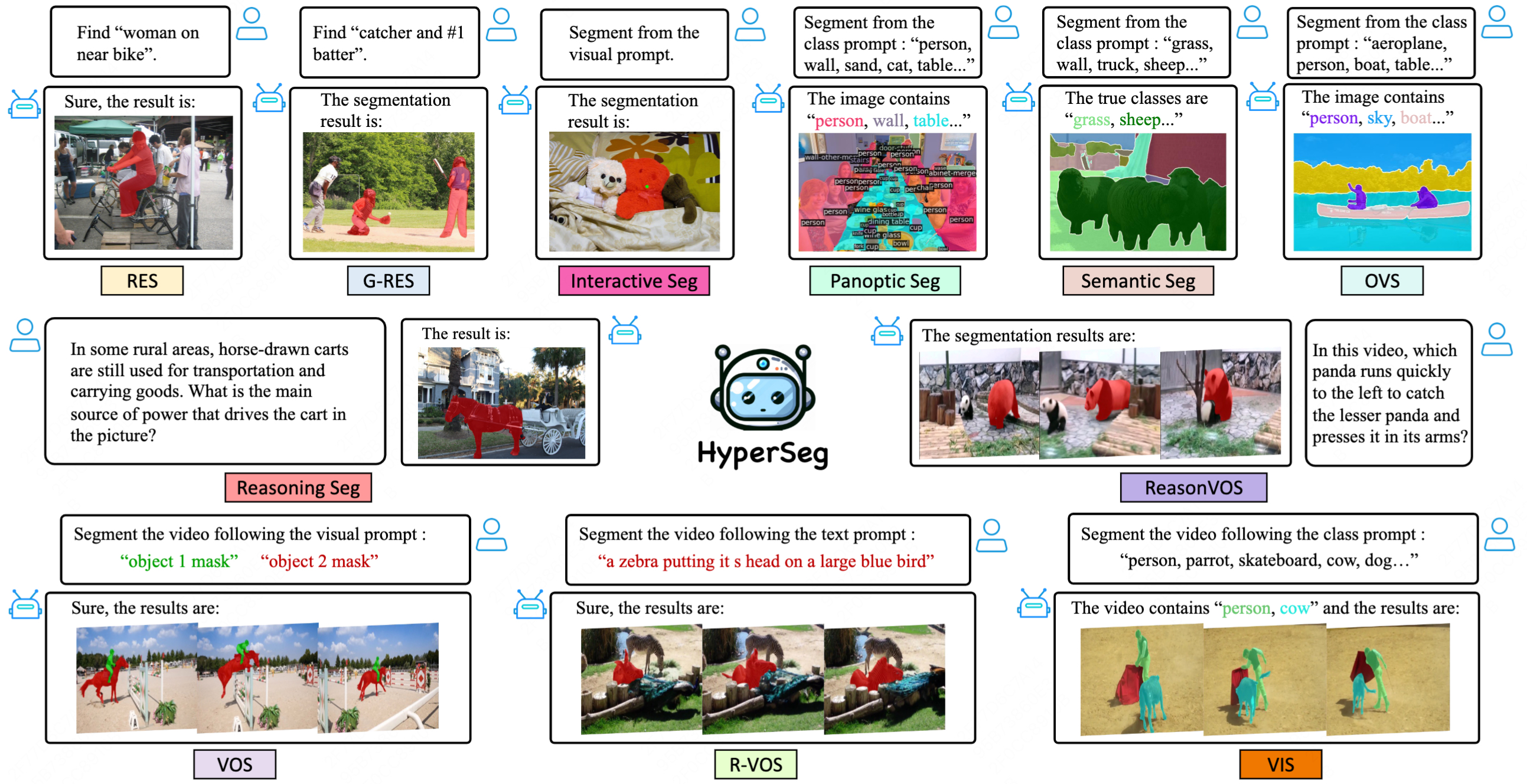

[RVOS]

TODO:

- 성능: 아래 벤치마크에서의 성능 향상, ‘가려짐’/’모션 블러’에서의 강점, 계산 효율성

- 요소: 새로운 아이디어

- additional..: 새로운 문제 정의, 기술 통합(ex. LLM, diffusion 결합)

- sota 분석해 보기

- Ref YouTube-VOS (challenge dataset)

paperswithcodePapers with Code - General Object Foundation Model for Images and Videos at Scale

Papers with Code - General Object Foundation Model for Images and Videos at Scale

Jointly trained on over ten million images from various benchmarks with diverse levels of supervision, GLEE excels in a wide array of object-centric tasks while maintaining SOTA performance.

- Video Instance Segmentation on OVIS validation (challenge dataset)

paperswithcodePapers with Code - DVIS-DAQ: Improving Video Segmentation via Dynamic Anchor Queries

Papers with Code - DVIS-DAQ: Improving Video Segmentation via Dynamic Anchor Queries

🏆 SOTA for Video Instance Segmentation on OVIS validation (mask AP metric)

paperswithcodePapers with Code - Context-Aware Video Instance Segmentation

Papers with Code - Context-Aware Video Instance Segmentation

🏆 SOTA for Video Instance Segmentation on OVIS validation (mask AP metric)

- RefCOCO

paperswithcodePapers with Code - HyperSeg: Towards Universal Visual Segmentation with Large Language Model

Papers with Code - HyperSeg: Towards Universal Visual Segmentation with Large Language Model

🏆 SOTA for Referring Expression Segmentation on RefCOCO+ val (Overall IoU metric)

- sota 논문들의 edge case(limitation) 살펴보기

Ideation:

- GPT

- *Referring Video Object Segmentation (RVOS)**는 주어진 자연어 문장(예: "빨간 모자를 쓴 사람")을 기반으로 비디오 내의 특정 객체를 프레임 단위로 정확하게 분할하는 문제입니다. 이 문제는 시공간적 특징과 언어 정보를 효과적으로 통합해야 하므로, 시간적 연속성을 잘 포착하면서도 언어-시각적 매핑이 중요한 역할을 합니다.

- Mamba (State Space Model; SSM)

- 핵심: 선형 상태공간 모델(SSM) 기반으로, 복잡한 순차 데이터(시퀀스)를 효율적으로 처리합니다.

- 장점:

- 장기 의존성(Long-range dependency) 학습에 강점

- 효율적인 병렬 처리 가능 (Transformer 대비 메모리 사용량 감소)

- 순차 데이터를 연속적으로 처리할 수 있음

- 약점:

- 공간적(Spatial) 관계보다는 시간적(Temporal) 관계에 더 최적화

- 복잡한 멀티모달(예: 언어-시각적 특징) 학습에는 추가 모듈 필요

- Transformer와의 비교

- Transformer는 멀티 헤드 어텐션(Multi-head Attention)으로 프레임 간 상호작용 및 객체 식별이 강력함.

- Mamba는 시간적 연속성에서 더 효율적이지만, Attention 메커니즘만큼 다양한 관계를 즉각적으로 포착하지는 못함.

- 시간적 일관성 (Temporal Consistency)

- Mamba는 프레임 간의 시간적 연속성 유지에 효과적입니다.

- 객체의 이동 및 연속된 프레임 간의 관계 학습에 유리합니다.

- 언어-시각적 특징 통합

- RVOS는 언어적 특징과 시각적 특징의 상호작용이 핵심입니다.

- Mamba 자체는 언어-시각적 통합에 특화되지 않았기 때문에, 언어 특징을 통합하는 추가 모듈이 필요합니다.

- 예를 들어 CLIP과 같은 언어-시각 모델을 Mamba와 조합하여 사용할 수 있습니다.

- 멀티모달 모델로 확장

- Mamba를 RVOS에 사용하려면, 비디오 프레임의 공간적 특징을 CNN(예: ResNet, ViT)으로 먼저 추출하고, 그다음 시간적 모델링을 Mamba로 수행하는 하이브리드 접근법이 필요합니다.

- 기본 구조:

- Backbone (시각적 특징): ViT, ResNet

- 언어-시각 통합: CLIP, Cross Attention 모듈

- 시간적 특징 모델링: Mamba (SSM)

- 기본 파이프라인 예시:

- 각 프레임에서 CNN/ViT로 공간적 특징 추출

- 언어 임베딩(CLIP)과 Cross Attention으로 통합

- Mamba로 시간적 관계 학습

- 최종적으로 Segmentation Head로 객체 분할 결과 생성

- 적합성: Mamba(SSM)는 RVOS의 시간적 연속성 유지에 강점이 있지만, 언어-시각적 통합 및 복잡한 공간적 관계를 단독으로 처리하기에는 한계가 있습니다.

- 추천 사용법:

- Backbone + Cross Attention + Mamba 조합으로 사용

- Transformer와 병렬 또는 보완적으로 사용하여 시간적-공간적 특징을 균형 있게 학습

자세히

Referring Video Object Segmentation (RVOS)에서 Mamba 아키텍처 및 SSM의 적합성

🐍 Mamba 및 SSM의 특징

🎯 RVOS에 Mamba/SSM 적용 가능성

🚀 권장 아키텍처

📊 결론

- 맘바 관련 논문들

Turing Post KoreaMamba 아키텍처 관련 연구 15選

Turing Post KoreaMamba 아키텍처 관련 연구 15選

Mamba 아키텍처 관련 연구 15選

- 맘바 세그멘테이션 잠재성 글

![[논문 정리] MambaOut: Do We Really Need Mamba for Vision?](https://velog.velcdn.com/images/bluein/post/0fda4971-d110-465c-8c36-4a6bfde9f551/image.png)

[논문 정리] MambaOut: Do We Really Need Mamba for Vision?

https://arxiv.org/abs/2405.07992